Wie der Begriff „Code“ bereits nahelegt, handelt es sich beim Binärcode um ein System zur Verschlüsselung beziehungsweise Darstellung von Informationen. Genauer gesagt werden die Informationen durch Sequenzen zweier sich unterscheidender Symbole dargestellt, wobei als Basis das Dualzahlensystem dient. Insofern geht die Bezeichnung „bi“ (zweifach oder doppelt) auf diese Form der Codierung durch zwei verschiedene Werte (1/0 = ein/aus) zurück. Aufgrund ihrer Einfachheit werden Binärcodes für die Verarbeitung digitaler Informationen generell in der Informationstechnik verwendet, zumal sie auch dort ihren Ursprung haben.

In der Digitaltechnik wird das Dualzahlensystem genutzt, wobei eine Zahlenstelle (Bit) eben nur zwei Werte annehmen kann (ein/aus). Das 1/0-Prinzip wird elektronisch durch Schaltzustände repräsentiert, die wie folgt aussehen können:

ein = high (H) = 5 V

aus = low (L) = 0 V.

Allerdings könnte man auch außerhalb der digitalen Welt mit Binärcodes bestimmte Informationen darstellen, die zwei Zustände (ein/aus) beschreiben sollen. Die einfachste Methode wären Rauchzeichen. Allerdings würde das im 21. Jahrhundert nur noch wenig Sinn ergeben.

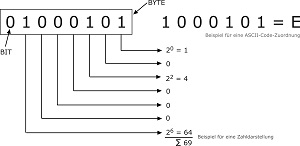

Mithilfe von Binärcodes lassen sich vor allem komplexe Themen sehr simpel in einfachen Informationseinheiten darstellen. Ein schlichtes Beispiel dafür ist: ein/aus, das heißt, Spannung liegt an (1) oder Spannung liegt nicht an (0). Die kleinste dieser Einheiten wird als Bit bezeichnet. Es ist nun lediglich eine Frage der Abbildung beziehungsweise Reihenfolge, mithilfe von Logikgattern bestimmte Codes darzustellen. Im ASCII-Code bedeutet beispielsweise die Bitfolge 1000101 ein E (Abbildung 116).

Sowohl das gebräuchliche Dezimalsystem als auch das Alphabet sind als Dualzahlen darstellbar. Die Dualzahl 1011 entspricht dem Term 23 + 21 + 20 und damit der Dezimalzahl 11. Alle Werte über 9 werden als Buchstaben dargestellt, zumal im ASCII-Code die Buchstaben des Alphabetes eindeutig bestimmten Zahlenwerten zugeordnet werden können. So entspricht die Dualzahl 1011 hier dem Buchstaben B.

Bit/Byte

Neben der kleinsten binären Einheit Bit (Binary Digit) wird darüber hinaus auch der Begriff Byte (nicht selten falsch) verwendet. Per Definition geht ein Byte auf die Bezeichnung „By Eight“ zurück, wonach der Umrechnungsfaktor eben 8 und nicht 10 entspricht. Deshalb gilt: 8 Bit = 1 Byte

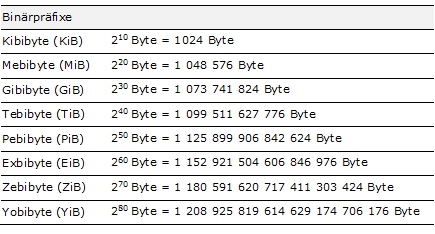

Insofern waren in den 1990er Jahren die Binärpräfixe üblich, die sich auf das 8:1-Verhältnis berufen.

1 Kibibyte (KiB) = 1024 Byte

1 Mebibyte (MiB) = 1024 × 1024 Byte = 1 048 576 Byte.

Allerdings wurde spätestens mit der Einführung von Computern im Heimgebrauch die Bezeichnung von Zweierpotenzen durch Binärpräfixe gemäß der bisherigen Norm IEC 60027-2 zu umständlich. Deshalb wurde durch das Internationale Büro für Maß und Gewicht (BIPM) die Empfehlung für neue SI-Präfixe ausgesprochen und damit die weltweite ISO-Norm IEC 80000-13:2008 (DIN EN 80000-13:2009-01) eingeführt. Vor diesem Hintergrund sind SI-Präfixe generell nur noch in der dezimalen Bedeutung üblich, wobei die Präfixe (Mega, Giga etc.) den entsprechenden Dezimalwert angeben:

1 Kilobyte (kB) = 1000 Byte

1 Megabyte (MB) = 1000 · 1000 Byte = 1 000 000 Byte.

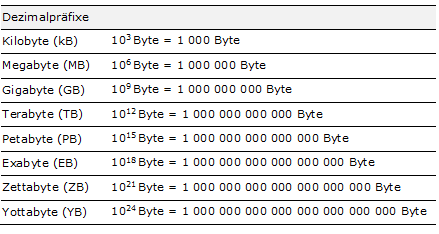

Die folgende Übersicht stellt die jeweilige Bedeutung und Zahlenwerte der Dezimalpräfixe dar, die sich in heute gängigen Bezeichnungen (z.B. Gigabyte/GB) wiederfinden:

Der Unterschied zu den ursprünglichen Einheitenvorsätzen auf Basis der binären Umrechnung (8 Bit = 1 Byte) wird in der folgenden Abbildung deutlich. Bei genauerer Betrachtung wird klar, dass die gerundeten Dezimalwerte geringer sind. Somit ergibt sich bereits bei 1 kB gegenüber 1 KiB eine Differenz von 2,40 Prozent, bei 1 MB/1 MiB von 4,86 Prozent und bei 1 GB/1 GiB von 7,37 Prozent.

Abbildung 118: Übersicht Binärpräfixe

Abbildung 118: Übersicht BinärpräfixeJedes Kind kennt heute die Dezimalpräfixe und die Bezeichnungen Byte und Bit. Allerdings werden diese nicht selten falsch angewendet, weshalb hier kurz umrissen werden soll, in welchem Zusammenhang die jeweiligen Begriffe ihre richtige Anwendung finden: Übertragungsraten (z.B. Downstream-Geschwindigkeiten 8 Gbit/s) werden in Bit und den entsprechenden Dezimalpräfixen (z.B. Giga = G) angegeben. Dateigrößen beziehungsweise Speicherkapazitäten oder Datenmengen im Allgemeinen (Festplattenlaufwerke, Arbeitsspeicher, CDs, DVDs, Blu-ray-Discs, USB-Speichermedien etc.) werden hingegen in der Einheit Byte angegeben (z.B. Festplatte: 2 TB/Flash-Speicher: 8 GB).

Bit Error Ratio (BER)

Verwirrung besteht ebenfalls nicht selten bei den Bezeichnungen Bit Error Rate (BER), Bitfehlerrate (BFR), Bitfehlerhäufigkeit (BFH), Bitfehlerverhältnis (BFV), Bitfehlerwahrscheinlichkeit (BEP). BER definiert das Verhältnis zwischen der Anzahl der fehlerhaften binären Signalelemente zu ihrer Gesamtzahl während einer Übertragung. Eine Bitfehlerhäufigkeit wird als Bitfehlerrate von beispielsweise „6x10exp-6“ dargestellt und beschreibt damit das einheitenlose Bitfehlerverhältnis (Bit Error Ratio: BER), was in diesem Fall bedeutet, dass bei einer Million übertragener Bits durchschnittlich sechs Bits falsch sein können. Ein Bitfehlerverhältnis (BER) von 10-4 entspricht einem fehlerhaften Bit auf 10.000 Bits.

Im Gegensatz zu den tatsächlichen Werten in der Praxis beinhaltet der Begriff Bitfehlerwahrscheinlichkeit (Bit Error Probability: BEP) lediglich theoretische Überlegungen zum wahrscheinlichen Auftreten eines Bitfehlers, wobei solche Wahrscheinlichkeitsberechnungen lediglich simulativen Charakter besitzen und für idealisierte Szenarien verwendet werden (beispielsweise in der Forschung). Grundsätzlich kann gesagt werden, dass BER die Qualität eines demodulierten Digitalsignals auf der Empfängerseite angibt. Dabei gilt: je niedriger das BER, desto besser das Signal.

Codec

Die Bezeichnung Codec beinhaltet sowohl das Codieren als auch das Decodieren als zwei kohärente Vorgänge. Als Kompositum vereint es die Wörter COder (Codierer) und DECoder (Decodierer). Hingegen definieren die Begriffe Konvertierung oder auch Transkodierung das direkte Umwandeln von einem Dateiformat in ein anderes (z.B. MP3 zu WMA).

In diesem Zusammenhang werden verschiedene Vorgänge und ihre Ergebnisse unterschieden. So kann es sich bei kodierten Dateiformaten sowohl um Audio- als auch um Videoformate handeln. Der MPEG-Standard spezifiziert sowohl Codecs als auch Containerformate, wobei MPEG-2- oder auch MPEG-4-Standards für Videoformate stehen. Ein MP3-Audiocodec erstellt beispielsweise MP3-Audiospuren und ist nicht mit dem MPEG-3-Standard zu verwechseln, den es im Übrigen nie gegeben hat (vgl. hierzu das Kapitel Videoformate).

Container

Das Containerformat beschreibt die innere Datenstruktur einer Containerdatei, also die Art und Weise, wie in einem Container beziehungsweise einer Containerdatei gespeicherte Datenformate angeordnet sind. Einfacher ausgedrückt: in einen Behälter werden mehrere Zutaten gepackt, die ganz unterschiedlicher Natur sein dürfen. Hauptsache, sie passen hinein. So können verschiedene Datenformate in einem Container zusammengefasst werden. Ein simples Beispiel ist eine ZIP-Datei, in der die Daten komprimiert oder „gepackt“ sind. Allerdings korrespondieren die Dateien hier nicht zwangsläufig miteinander. Anders verhält es sich zum Beispiel bei Audiodaten in Verbindung mit Zusatzinformationen (MP3) oder aber zusammengeführten Video- und Audiodaten, die in der Summe einen Film ergeben. Hierfür werden im Alltag zumeist folgende Formate verwendet: MP4 (*.mp4), Matroska (*.mkv, *.mka), DivX (*.divx) oder auch AVI (*.avi). Genau wie Codes werden Containerformate von einem Multiplexer erstellt.

Chroma Subsampling

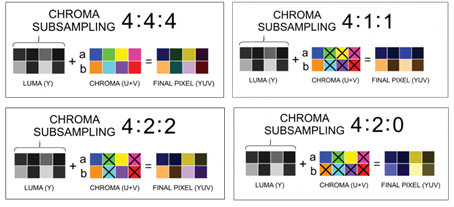

Der erste Schritt der Datenreduktion ist innerhalb vieler Kompressionsverfahren das sogenannte Chroma Subsampling. Dabei wird die Auflösung der Farbinformation (Chrominanz-Signal) gegenüber den Informationen über die Helligkeit (Luminanz-Signal) vernachlässigt. Man spricht auch von der Farbunterabtastung. Basis dieses Verfahrens ist ebenfalls die menschliche Wahrnehmung und damit verbunden die Anatomie des Auges, das Helligkeitsunterschiede besser wahrnehmen kann als Farbunterschiede. Unser visuelles System reagiert unterschiedlich auf Farbfrequenzen, weshalb Bilder (ähnlich wie Töne) auch als Überlagerung zweidimensionaler Schwingungen dargestellt werden können. In diesem Zusammenhang sind niedrige Bildfrequenzen für grobe Bildstrukturen und hohe Bildfrequenzen für feine Details verantwortlich. So können hohe Frequenzen besser komprimiert werden, ohne dass das menschliche Auge den Datenverlust wahrnimmt. Diese Frequenzabhängigkeit wird in allen Videokompressionsverfahren der MPEG-Standards ausgenutzt.

Insofern bedeutet Farbunterabtastung oder auch Subsampling nichts anderes, als dass die Abtastrate reduziert beziehungsweise der räumliche Abstand der Abtastpunkte der Farbinformation verringert wird. Die Farbinformation kann so mit einer geringeren Bandbreite übertragen werden. In der Regel sind die folgenden vier Varianten der Farbunterabtastung bekannt.

4:4:4 (1x1,1x1,1x1)

Hierbei handelt es sich eigentlich um keine Farbunterabtastung, da im 1:1-Verhältnis abgetastet wird, wie etwa beim RGB-Signal, bei dem das Luminanz- und alle drei Farbartsignale getrennt übertragen werden.

4:2:2 (2x1,1x1,1x1)

Diese Variante stammt ursprünglich aus dem analogen Farbfernsehstandard NTSC, wird aber ebenfalls für digitale Videosignale verwendet (ITU-R BT 601). Hier wird zwischen der horizontalen und vertikalen Farbunterabtastung unterschieden, wobei die Horizontalabtastung nur halb so hoch ist wie die vertikale.

4:1:1 (4x1,1x1,1x1)

Auch wird die Farbabtastrate in horizontaler Richtung nochmals halbiert und entspricht einem Viertel der Abtastrate des Helligkeitssignals.

4:2:0 (2x2,1x1,1x1)

Die Abtastrate ist hier in beiden Raumrichtungen (horizontal/vertikal) identisch, allerdings sind die Abtastpunkte des Farbsignals leicht versetzt. Diese Form der Farbunterabtastung wird insbesondere bei den Standards JPEG und MPEG verwendet. Bei JPEG erfolgt eine zentrische Abtastung, bei MPEG wird das Farbsignal in gleicher vertikaler Ausrichtung wie das Helligkeitssignal abgetastet.

Darüber hinaus hat beispielsweise die Firma Sony die 3:1:1-Farbunterabtastung geprägt (DVCAM/DV SDL). Ein neueres Verfahren (22:11:11) nach der Norm SMPTE 292M ist im HDTV-Bereich auf der HD-SDI-Schnittstelle zu finden.

Allerdings kommt es bei der Farbunterabtastung auch zu unerwünschten Nebeneffekten, die insbesondere im Wiedergabegerät vorgenommen wird, um Datenvolumen zu sparen. Diese interne Farbunterabtastung erfolgt über eine Software und ist im Fernseher fest integriert. Ist eine solche vorhanden, kann sich vor allem die Wiedergabe von Fotos und künstlichen Grafiken auf dem Display verschlechtern, schmale Linien oder kleine Details werden unscharf dargestellt oder können sogar komplett verschwinden.

Zur Überprüfung der Bildqualität des Displays sollte auf professionelles Testmaterial zurückgegriffen werden. Hierzu eigenen sich Testbilder, die allerdings ausschließlich zur Bildbeurteilung nicht aber zur Bildoptimierung dienen. Im TV-Display-Labor der Firma BUROSCH wurde hierzu eigens zur Überprüfung der internen Datenkomprimierung von modernen TV-Displays ein Testbild entwickelt (Subsampling Test Pattern), mit dem überprüft werden kann, ob ein TV-Gerät eine interne Farbunterabtastung vornimmt oder nicht.